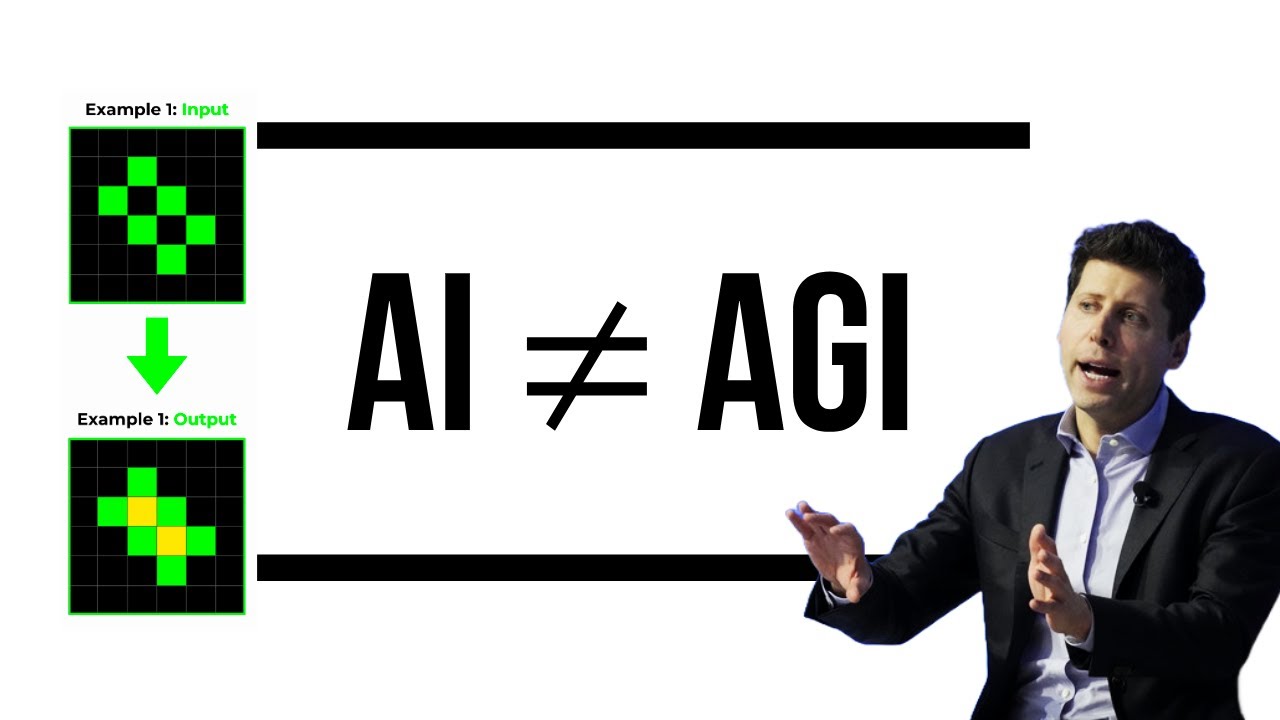

この格子状のパターンを見て、どのように左の格子が右の格子に変換されているかわかりますか? 同じように、左側のこの格子がどのようにこの格子に変換されているかわかりますか? そのパターンに気づきましたか? 言い換えれば、このテスト例の格子にどのようなことが起こるか予測できますか?

GPT-4のような言語モデルはこれができないことに驚くかもしれません。格子の小さな四角が濃い青色で塗りつぶされていることに気づくのが苦手なのです。このような特定の抽象的な推論の課題は、GPT-4のトレーニングデータセットには含まれていなかったため、そのモデルは見たことのあるものから一般化して課題を解決することができないのです。これは一般的な知性ではなく、人工汎用知能(AGI)でもありません。

些細なことのように思えるかもしれませんが、現在の世代のAIがAGIではなく、正直言って全く近づいていない理由の核心に迫っています。もちろん、モデルを単純にスケールアップしても、この問題は解決しません。しかし、このビデオは、現在のLLMsの1つの欠点を指摘するだけではありません。AIが過大評価されているのか、過小評価されているのかという渦巻く議論に対処するための私の試みでもあります。

多くの人にとって、AIは誇大広告に過ぎず、巨大なバブルです。一方、他の人にとっては、AGIはすでに到来しているか、あるいは数か月以内に到来すると考えています。しかし、意見は必要ありません。証拠は何を示しているのでしょうか? このビデオでは、数十の論文やレポートを参考にして、LLMsとAIについて、できる限りベストなスナップショットをお届けします。

まずは、残念ながら、現在の AIの風景の多くに見られる問題点から始めます。リリースの遅れ、過剰な約束、そして現在私が最も懸念しているのは、AIスロップによる共有地の悲劇です。しかし、私は、風呂の水と一緒に赤ちゃんを捨ててしまうかもしれない人に注意を促します。今日のLLMsから、はるかに強力で有用なモデルへの6つの詳細なエビデンスベースのパスを示します。それは、先ほどお見せした抽象的な推論チャレンジでも、それなりのパフォーマンスを発揮するシステムを含みます。

しかし、まずは「AI」の怪しい部分から始めましょう。いえ、このARC AGIチャレンジの創設者や出資者が、現在の世代のLMsが成功しないと非常に確信していて、100万ドル以上の賞金をかけていることを指しているのではありません。GPT-4が純粋な推論エンジンだとしたら、なぜこのチャレンジでパフォーマンスがほとんどないのでしょうか?

でも、実際に私が言及しているのは、過剰な約束と不十分な成果の風景です。Googleが最初のGeminiモデルを発表したとき、デミス・カビスが「人間の専門家と同じくらい優れている」と言及したことを覚えているかもしれません。しかし、Googleは、LLMを搭載したAIの概要機能を後退させなければなりませんでした。間違いが多すぎたからです。

一部のベンチマークで示されているように、Geminiが人間の専門家と同じくらい優れているのであれば、なぜランダムなGoogle検索よりも優れていないのでしょうか? しかし、きっと新しく発表されたApple Intelligenceの方がはるかに優れているはずです。テストすることはできませんが、ティム・クックは、まだ絶えず幻覚を見ていると認めています。

一部の人にとっては、実際にはそれがLLMsのポイントなのですが、創造的であってほしいと思っています。しかし、他の人にとっては、それはより多くのBSのように感じられます。この特定の論文は、かなり面白いだけでなく、1つの明確なメッセージを伝えています。言語モデルは、正しいことを目的として設計されているわけではありません。情報を伝えるために設計されているわけではないので、その主張が誤りであることがわかっても驚かないでください。

もちろん、人々はそれに取り組んでいて、論文でも「Let’s verify step-by-step」という論文に言及しています。後ほど詳しく説明しますが、要点は変わりません。AIにはさまざまな幻覚があり、AIに関するマーケティングにも幻覚があります。AI搭載の歯ブラシがあるからといって、それが私の最大の関心事ではありません。

Rabbit R1やHumane AI Pinのような過大評価された製品が時折あることも、実際には私の最大の関心事ではありません。Microsoft Recallのような機能が必然的に招きそうなプライバシーの侵害の可能性もあります。数秒ごとにデスクトップのスクリーンショットを撮って分析させるのは、私にとっては魅力的ではありません。Open AIのツールを使って作成したものをLLMが選り分けようとするのを想像してください。

学術論文の執筆や推敲にLLMを使用する研究者の増加についてはどうでしょうか。PubMedの論文で「delve」という単語の使用が最近急激に増加しているのがわかります。私は、読んでいる記事がLLMによって生成されたものだと疑った瞬間、それを大幅に割り引いて考えます。

次に、リリースの遅れがあります。これはおそらくもう少し許容できるかもしれませんが、GPT-4は数週間以内に提供されることを約束されていました。機能が発表された瞬間に実際に利用できるという伝統があれば、私たち全員がそれを好むと思います。GPT-4については後ほど触れます。

あなたとは違うかもしれませんが、現時点での私の最大の懸念は、AIが生成するスロップです。LinkedInでは、自分の分野や業界の誰かの文章を模倣するツールがあります。彼らがバイラルになっている間、あなたはほとんど、あるいは全くエンゲージメントを得られていないのでしょうか? 彼らのトーンをコピーして、同じトピックに取り組んでください。

これを使う個人にとっては、おそらくかなり役立つでしょう。エンゲージメントを高め、言語の問題を解決するのに役立つはずです。しかし、最近Facebookで見られるように、それは単にこの一般的なAI生成のミアズマにつながるだけです。ボットがボットと交流し、信じやすい人々が引き寄せられ、だまされる。見たり聞いたりするものを信じられなくなる風景です。それは、ディープフェイクのトピックに入る前の話です。もちろん、関係する個人に深刻な影響を与える可能性があります。

同意するかどうかは教えていただければと思いますが、私にとって現時点での最大の懸念事項であり、この時点でそれを止める方法を見つけるのは難しいでしょう。

おそらく、これはAIに対してかなりネガティブだと思われるでしょう。しかし、ご覧のようにビデオにはまだ十分な時間が残っています。

しかし、この時点で、ある人々に対する私の反論は、正反対の陣営に陥るのは簡単すぎるということです。昨年、加速主義者と終末論者の間で見られたように、今年は、AIは誇大広告に過ぎないと言う人とAGIは差し迫っていると言う人の間で見られます。しかし、世界ははるかに複雑だと思います。

私が盲目だったら、GPT-4の時々の幻覚を許し、私の周りの世界について教えてくれるモデルに感謝するでしょう。そして、インタラクティブにリアルタイムで、彼らが今まさに何をしているのかを正確に教えてくれます。

今、アヒルたちは水の上を静かに滑っています。かなりリラックスした様子で、急いでいる様子はありません。時折、1羽のアヒルが頭を水の下に入れて、おそらく食べ物を探し、また浮上してきます。オレンジ色のライトをつけたタクシーが来るのもわかります。家に帰るためにそれを呼び止めるつもりです。

はい、今、道路の左側に向かって走っているタクシーを1台発見しました。タクシーを呼び止める準備をしてください。

そのタクシーをうまく呼び止めましたね。タクシーに乗る準備は整ったようです。タクシーに乗り込む道案内をしてくれる良い犬ですね。安全な旅を。

ちなみに、Googleの Project Astra が示したように、モデルはますます多くのトークン、つまりより多くのコンテキストを取り込むことができるようになっています。テキストだけでなく、現実世界でも、あらゆる種類のユーザーが物事を見つけるのを助けることができるようになっています。

LLMsについてはすぐに戻ってきますが、もちろん、ニューラルネットワークにはLLMs以外にもはるかに多くのものがあることを覚えておく価値があります。Natureの新しい研究では、Gans (generative adversarial networks)を使って、マウスに対する未検査の化学物質の影響を予測する方法が示されました。この場合、Gen AIは、仮想的な動物実験をシミュレートして、従来の動物研究から得られるプロファイルと同様のプロファイルを生成することができました。

要点は、Gen予測の誤差が少ないだけでなく、はるかに迅速に生成されたことです。BBCが報告したように、これは動物実験を終わらせるための少なくとも1つの試みの一歩です。

そして、もちろん、画像解析のための古き良きConvolutional Neural Networksがあります。NHS の Brainix E stroke システムでの使用は、現在、脳卒中の犠牲者を助けています。本質的に、それは臨床医がはるかに迅速に診断を下すことを可能にしました。脳卒中の場合、これは非常に重要です。もちろん、それによって回復する患者の数が3倍になりました。

私が唯一小さな不満を言うとすれば、いつものようにタイトルに「AI」という語句が使われていることです。実際に使用されている技術を探し出すのに、気持ちが悪くなるほど時間がかかりました。それでも、もちろん商業的な理由から、彼らはすべてを言っているわけではありません。

しかし、今は大規模な言語モデルに話を戻したいと思います。このチャンネルの中心的な焦点です。私は過去にこのチャンネルで、現在の世代の大規模言語モデルに見られる推論のギャップについて議論してきました。しかし、今週、伝説的なFrancoiis Choletによって宣伝されたARC抽象的推論チャレンジと賞金は、現在のモデルが正確に何を見逃しているのか、そしてそのギャップを修正するために何が行われているのかを明確にする絶好の機会です。

少なくとも以下のことで、なぜ私たちのモデルが時にショッキングなほど愚かで、時にショッキングなほど賢明であるのかを説明できればと思います。私は、GPT-4のようなモデルが一貫して失敗する種類のチャレンジの例を1分間バックグラウンドに残しておきます。

では、現在の問題は60秒で何でしょうか。言語モデルが何かの解決策をトレーニングデータで見たことがない場合、テストしたときにその解決策を提供することができません。だから、モデルはこのチャレンジに失敗するのです。これらのテストを以前に見たことがないからです。

さらに、モデルは一般的に知的ではありません。何百万ものこのような例でモデルをトレーニングすることができ、人々はそれを試みてきましたが、新しい例では依然として失敗します。その新しい例がトレーニングデータセットに含まれていない場合、モデルは失敗します。

Gabriel Mackの母親がデータセットに含まれていれば、正しい答えを出力します。しかし、Suzan Victoria Puliaの息子のデータがデータセットに含まれていない場合、モデルはそれを知りません。トレーニングデータの他の部分に基づいて答えを推論することはありません。

では、数学のベンチマークのように、特定のベンチマークでモデルがとてもうまくできるのはなぜでしょうか? 以前に見たことのある特定の推論チェーンをトレーニングデータセットから「思い出す」ことができるからです。それは特定の状況で正解を得るのに十分です。

つまり、彼らは特定の推論手順、つまりプログラムを思い出すことができるが、それらを作成することはできないのですね。そうです。良いニュースと悪いニュースの状況です。

しかし、このビデオの残りの部分、実際にはLLMsの残りの部分では、この区別を覚えておくことが重要になります。推論手順やプログラムを思い出すことと、新しい推論自体を行うこと。以前に見たことがあれば素晴らしい。以前に見たことがなければ、そうでもない。

さて、このフレームワークに対する反応として、次のような考えを持ったかもしれません。言語モデルをあらゆる推論手順でトレーニングし、遭遇する可能性のあるあらゆるシナリオのデータを与えれば、それがAGIにならないのでしょうか?

ここでは、ARCチャレンジの作者であるFrancois Choletが、なぜ暗記だけでは不十分なのかを説明しています。私たちは世界の全体像を見ていないからです。もしあなたの人生が静的な分布であるなら、可能な行動の空間を力ずくで解決することができるでしょう。

知性は、未来の状況空間におけるパス探索アルゴリズムと考えることができます。RTSゲーム開発に詳しくない方もいらっしゃるかもしれませんが、マップがあります。2次元のマップです。部分的な情報しかありません。探索していない領域があり、それらについては何も知りません。

そして、探索した領域もありますが、過去にどのようなものだったかしか知りません。今、2次元ではなく、遭遇するかもしれない未来の状況の空間について考えてみましょう。そして、それらがどのように互いに結びついているかを考えてみましょう。

知性は、パス探索アルゴリズムです。目標を設定すると、最適にそこに到達する方法を教えてくれます。しかし、もちろん、それは持っている情報によって制約されます。何も知らない領域でパスを探索することはできません。

マップに関する完全な情報があれば、単にあらゆる可能なパスを記憶することで、パス探索問題を解決することができます。A地点からB地点へのマッピングをすべて記憶すれば、純粋な記憶で問題を解決できます。

しかし、現実の世界では、将来何が起こるかを実際には知らないので、それができない理由がそこにあります。AIが新しい状況に遭遇する場合、その場で適応する必要があります。

それについて私の考えを変えさせるのは、基本的に次のようなことです。トレーニングデータの観点から実際に新しいタスクである、以前に見たことのないものをモデルに示したとき、それが実際にその場で適応できるという事例の臨界量を見始めたら。

そして、それは思ったよりも可能かもしれません。Open AIのGnome Brownは、LLMがそれを解決すると楽観視しています。しかし、繰り返しになりますが、データを単純にスケールアップするだけでは、そこにたどり着くことはできません。

例がない、つまりゼロショットの場合、モデルは見たことのあるものから見たことのないものへ一般化しません。この論文は、視覚の領域でそれを示しています。テキストの領域ですでに見てきたように。

彼らがテストしたニューラルネットワークアーキテクチャやパラメータスケールに関係なく、モデルはデータを必要としました。人間の子供とは異なり、サンプル効率の高い方法で学習しませんでした。

子供にラクダの画像を1枚見せて、「ラクダ」というキャプションをつけると、一生そのラクダという言葉を覚えているかもしれないことを忘れないでください。

しかし、この論文の途中で、このチャレンジを克服する方法についてのいくつかの暫定的な証拠がありました。高容量モデルの場合、めったに見つからない概念でもかなりの結果が得られることが指摘されています。

それらは、長い尾を持つ分布の長い尾を指すlet-it-wagデータセットで表されていました。とにかく、ご覧のように、この伝統的でよく知られた画像ネット精度テストで80%以上の性能を示したモデルは、この長い尾のデータセットでもかなりの性能を示しました。

彼らが指摘するように、パフォーマンスのギャップは、より高い容量のモデルで減少しているようです。言い換えれば、より多くのデータは間違いなく役立ちます。特に指数関数的により多くのデータは。しかし、それだけでは十分ではありません。

しかし、この論文でさえ、このチャレンジを克服する方法をいくつか指摘しました。検索メカニズムだけでなく、構成的な一般化の可能性も指摘しています。言い換えれば、トレーニングデータセットで見つかった概念を組み合わせて、より複雑なものを認識できるようにすることです。

そしてもしそれが不可能だと思うなら、私はあなたに朗報があります。ちょうどその前に、この非常にマニアックな人物、物体、またはトピックに関する私の回答に非常に正確な情報が含まれている場合、つまりインターネット上で1回か2回しか見つかりそうもない種類の情報が含まれている場合、クロードはその回答の最後に、このような質問に対して幻覚を見る可能性があるという簡潔なリマインダーを付け加えます。そして、「hallucinate」という言葉を使って、ユーザーが何を意味しているのかを理解できるように説明します。私の回答の情報がインターネット上に何度も存在する可能性が高い場合は、たとえその人物、物体、またはトピックが比較的マニアックであっても、この注意書きを追加しません。それはライティング、分析、質問への回答、数学、コーディング、その他あらゆる種類のタスクを手伝うことを喜んでいます。コーディングにはマークダウンを使用します。人間の質問に直接関連していない限り、自分自身に関するこの情報には触れません。

そのような構成性について私が少し前に触れたのは、昨年末にNatureに掲載されたこの論文についてです。おそらくモデルは推論できませんが、推論ブロックをより複雑なものに構成できるようになれば、それで十分でしょうか?

著者らは、少なくとも原理的には、わずか140万のパラメータを持つTransformerベースのモデルでその点を証明しました。大胆にも彼らは主張します。「我々の結果は、構成的スキルに最適化された標準的なニューラルネットワークアーキテクチャが、人間の系統的一般化を直接比較で模倣する方法を示しています」。

論文の第一著者がリツイートしたように、より良いAIへの答えは、おそらくより多くのトレーニングデータだけではなく、トレーニング戦略の多様化にあるのです。要約すると、ロボットを時々代数のクラスに送ってください。

チャレンジは、左下に示されているように、これを思い出させるかもしれません。少し前にお見せしたARCチャレンジのようなものです。このチャレンジは、左に示されたルールに基づいて、この作り上げられた言語の断片が実際に何を意味するのかを理解することでした。

十分な時間があれば、人間はこのチャレンジをかなりうまくこなすことができます。ARCチャレンジのように。しかし、GPT-4のようなモデルは、ご覧のようにひどい失敗をします。GPT-4は1.8兆のパラメータを持っていますが、彼らがトレーニングしたモデルは140万のパラメータしかありません。

とにかく、十分な時間があれば、あなたの場合は人間として、彼らのTransformerモデルの場合はトレーニングで、それはwhoがtoを意味し、sがgreenを意味し、reがlight blueを意味することを理解しました。もちろん、他のルールもあります。そして、それらのルールを組み合わせて、質問の答えを導き出さなければなりません。

テストされたときは、トレーニングされていない新しい単語の構成でテストされたことを覚えておいてください。作り上げられた新しい言語のルールを「理解」し、それを適用しなければなりませんでした。それができたのです。

言い換えれば、真の推論の最初のほのかなヒントを示したのです。ただし、AGIに向けての非常に小さな一歩に過ぎません。なぜなら、これらの構成的推論のきらめきを新しいタスクでテストしたとき、この小さなモデルは失敗したからです。

さて、次のアプローチの時間です。言語モデルにはこれらの推論の連鎖やプログラムがあるように見えますが、チャレンジを解決するのは難しいようです。では、言語モデル内のそれらのプログラムを見つける能力を向上させる方法はどうでしょうか?

今週、検証機とモンテカルロ木探索を使って言語モデルの数学的推論を改善することについて、一連の論文が発表されました。もちろん、それらすべてを取り上げるのは、それ自体が1本のビデオになるでしょう。しかし、要するに、それは次のようなことです。

推論の連鎖における間違ったステップを認識するようにモデルをトレーニングすることができます。let’s verify step-by-stepを使って、悪いプログラムを選び出すのです。このチャンネルでは何度も取り上げてきましたが、それには人間のアノテーションが必要でした。

しかし、Google DeepMindは、正解につながる結果と、不正解につながる出力を自動的に収集することで、自動化された方法でこれを行うアプローチを考案しました。彼らは、言語モデルの出力の各ステップを分析し、決定するプロセス報酬モデルをトレーニングしました。

これまでこのビデオで使ってきたアナロジーを使えば、プロセス報酬モデルは、言語モデルが欠陥のある不適切なプログラムを呼び出した瞬間に警告を発することができます。理論的には。

しかし、少なくともこの論文では、このアプローチには限界があります。100以上の解を分析して決定しても、パフォーマンスはプラトーに達し始めました。確かに、この数学ベンチマークでは50%から約70%へと大幅な向上が見られましたが、限界があります。

それは、let’s verifyのように人間のアノテーションを使用していないからでしょうか? それとも、このアプローチに根本的な限界があるのでしょうか? おそらく、言語モデルが数学の問題を解くのに必要なプログラムをトレーニングデータセットに持っていなければ、どんな監督を受けても解くことができないのかもしれません。

それでも、原理は明確に確立されています。言語モデル自身がチャレンジを解決するための正しく必要なプログラムを見つけることに頼る必要はありません。少なくとも、その過程を助けることはできます。

そして、シミュレーションや現実世界など、さらに優れた検証器が存在することを私たちは知っています。Dr. Eurekaの論文の筆頭著者であるJason Mahと議論したように。

それは特徴です。つまり、LLMは100種類の異なる解を抽出することができ、この場合はシミュレーターが外部の検証器として機能し、どの解が良いかを確認することができるのです。

LMに幻覚を見る能力がなく、常に決定論的であれば、その方法は実際には機能しません。イテレーションごとに1つの候補しか生成できないからです。そうなると、非常に遅くなります。

モデルが何らかの応答を生成するたびに、技術的には幻覚を見ているのです。それは単に確率分布からのサンプルなのです。それが自分が出力すべきだと思うものと一致しない場合にのみ、幻覚なのです。

しかし、私の場合は、モデルが良い報酬だと思うものと一致するかどうかは気にしません。外部で検証するものがあるのです。モデルが100種類の異なるものを出力できるのは素晴らしいことだと思います。反復的な進化のプロセスをはるかに速くしてくれるからです。

チャットボットエージェントのようなアプリケーションについてのみ考えている場合は、過小評価してしまうかもしれませんが、大規模言語モデルや任意の基盤モデルの発見タスクや科学的発見のユースケースについて考えると、モデルが10の異なる解決策を提案できることが望ましいのです。

幻覚を弱点から強みに変えることは可能でしょうか? Nvidiaなどは、それを明らかにするために懸命に取り組んでいます。

2つ目のアプローチは、大規模言語モデル内の必要なプログラムをより良く見つけるために、検証器などを使用することに要約できます。そして、潜在的な知識を見つけるもう1つの方法を簡単に述べます。

many-shotは、達成したいタスクの種類の例を大量にモデルに与えます。そうすることで、より良く行う方法を学習することができます。当たり前のように思えますが、パフォーマンスを大幅に向上させることができます。

しかし、その場でモデルに新しいプログラムを教えるのはどうでしょうか? これは、フランソワ・ショレが「アクティブ推論」と呼んでいるものであり、現在のARC AGI賞で34%という最先端のスコアを出すのに貢献しています。

このアプローチには多くの側面がありますが、私は大幅に要約します。主な洞察は、モデルが左のような3つの例を見たときに、4つ目の例を解決する方法を教えるには不十分だということです。

そのわずかなシグナルでは、多くのパラメータの中に埋もれてしまいます。しかし、Jack Coleたちが行ったことの1つは、これらの3つの例を、スタイルを模倣した多くの合成例で補強することです。

そして、彼らはそれらの拡張された例でモデルをファインチューニングします。人間がするように、目の前のものに優先順位を付けていると考えることができます。パラメータは、手元のタスクに集中するように調整されます。人間がフローに入るのと少し似ています。

ちなみに、彼らはGPT-4を使って、システムをトレーニングするための多くの合成なぞなぞを生成しています。フランソワ・ショレは、このアプローチを次のように説明しています。

ほとんどの場合、LLMを使用しているときは、単に静的な推論を行っているだけです。モデルは固定されていて、プロンプトを与えると答えが返ってくるだけです。モデルは実際には何も学習していません。状態は手元のタスクに適応していません。

そして、Jack Coleが実際に行っているのは、すべてのテスト問題に対して、その場でLLMのバージョンをファインチューニングすることです。それが実際にパフォーマンスを引き出しているのです。

それを行わなければ、1% 2%程度の完全に無視できるようなものになります。そして、テストタイムのファインチューニングを行い、その上にいくつかのトリックを追加すれば、興味深いパフォーマンス数値になります。

だから、彼がしていることは、今日のLMsの主要な制限の1つ、つまりアクティブ推論の欠如に対処しようとしているのだと思います。彼は実際にLMsにアクティブ推論を追加しているのです。そして、それは非常にうまくいっています。

これは私にとって興味深いことです。フランソワ・ショレが言うように、これはプログラム合成のようなものです。もう1つの定義は、推論は、パズルに直面したときに、それを解決するためのプログラムがメモリにまだない場合に、既存のプログラムの一部から新しいプログラムをその場で合成する能力だと言えます。

記憶されたプログラムを取り出して再生するよりも、その場でのプログラム合成を行う方がはるかに難しいのです。

さて、このビデオのこの時点で、4つ目のアプローチに入るところですが、私は告白します。LLMsを改善する方法に関連する他の論文が画面上に約20個のタブが残っていますが、このビデオが少し長すぎるのではないかと心配になってきました。

ですので、最後の数個のアプローチについては、もっと簡潔に説明します。それでも、中心的なメッセージは伝わっていると思います。LLMsは現在、抽象的な推論が苦手ですが、それは死刑宣告である必要はありません。

文献には、AGIがすぐに来ることを示すものはありませんが、AIがすべて誇大広告だというわけでもありません。

ここにあるのは、LLMsの懐疑論者であるRaul教授の論文です。私は約1年前に彼にインタビューしました。これは今週の立場表明論文です。LMsはプランを見ることができますが、LLMモジュール型フレームワークでのプランを助けることができます。

私たちは約1年前に素晴らしい議論をしました。これについては別の動画で取り上げたいと思います。しかし、この論文の要約は次の通りです。

以前のRaul教授らの研究では、GPT-4のようなモデルでさえ、一貫したプランを立てることができないことが示されていました。彼らはこのBlocks Worldの分野で失敗しています。

本質的に、Blocks Worldは、今日見てきた他の推論チャレンジのようなものです。ブロックを積み重ねたり、積み替えたりして、必要な目的を達成するための一貫したプランを立てなければなりません。

これは明らかに暗記テストではありません。MMLUがそうであるように。実際、モデルを混乱させて、身近なオブジェクトの代わりに神秘的な言葉を使うと、モデルのパフォーマンスはさらに悪くなります。ゼロショットのGPT-4は、600のチャレンジのうち1つしか解けません。

しかし、この4つ目のアプローチでは、なぜLLMsだけを使わなければならないのでしょうか? 伝統的なシンボリックシステムと一緒に使えばいいのではないでしょうか? ニューラルネットワークと伝統的なシンボリックなハードコードされたプログラム的なシステムを組み合わせることで、どちらか一方だけよりも優れているかもしれません。Raul教授は、LLMの懐疑論者であるYann LeCunの友人ですが、彼が主導した論文では次のように述べています。

「計画におけるLLMsの役割について、根拠のない悲観論がある」と。重要な洞察は、LLMsがアイデアジェネレーターとして機能できるということです。そして、グラウンドされたシンボリックシステムがそれらのプランをチェックできるのです。

LLMsはアイデアマンとして、シンボリックシステムは会計士のようなものです。LLMsは、Blocks Worldのチャレンジを解決するための候補プランを推測するのに優れています。そして、それらのアイデア、つまり取り出されたプログラムは、すべて悪いわけではありません。

シンボリックシステムからのフィードバックを3、4回行った後でも、最終プランの50%は、最初の大規模言語モデルのプランの要素を保持しています。そのシンボリックシステムからのフィードバックを使って、LLMにプロンプトを与え直し、うまくいけば、より良いプランを考え出してくれるのです。

これは、私が別の動画で取り上げたAlpha Geometryを思い出させました。今日は重点的に説明しませんが、幾何学の問題、特に国際数学オリンピックの問題に対して、ニューラルネットワークとシンボリックシステムを組み合わせたものです。

それはほぼ金メダルを獲得しました。それらは信じられないほど難しい推論チャレンジです。

5番目のアプローチは、別のシステムを呼び出す代わりに、その知識を共同でトレーニングするというものです。時間の関係上、ここでは非常に簡単にまとめます。

彼らは、言語モデルではなく、別のニューラルネットワーク、この場合はグラフニューラルネットワークをトレーニングしました。それは専門のアルゴリズムを学習しました。

そして、彼らはその固定された最適化されたノウハウを埋め込み、言語モデルにそれらの埋め込みへのアクセスを持たせてトレーニングしました。

言い換えれば、テキストの言語とアルゴリズムの言語、例えばソートに必要なプログラムの両方に精通した言語モデルです。

最後に、このビデオのために、タシットデータがあります。人間が行うこと、人間が推論する方法の多くは、書き留められていません。

地球上で最も賢明な男と言っても過言ではないテランと聞いてみましょう。彼は次のように言いました。

「多くの知識は、何らかの形で個々の数学者の頭の中に閉じ込められており、そのうちのごく一部だけが明示的になっています。数学者の直感の多くは、ジャーナルの印刷された論文には捉えられていません。数学者同士の会話や講義、学生への助言の仕方の中にあるのです」

「人々は成功談しか発表しません。本当に貴重なデータは、誰かが何かを試して、それがうまくいかないけれども、どうすれば直せるかを知っているときのデータです。しかし、彼らは成功したことだけを発表し、そのプロセスは発表しません」

そして、彼によれば、これらすべてが、AIを劇的に改善する方法を指し示すと同時に、知性の爆発が差し迫っていない理由も指し示しているのです。

その暗黙知をトレーニングすることで、著しい進歩が望めるでしょう。しかし、彼によれば、人間の数学者はより高度な数学に移行するだけだそうです。

現在、OpenAIをはじめ多くの企業が、その暗黙知を可能な限り明示的にしようとしています。おそらく何百人ものPhDが、問題を解決する際の方法論を書き留めているでしょう。何百万時間、いや何十億時間ものYouTube動画が取り込まれ、AIモデルがその暗黙の推論の一部を拾い上げることが期待されています。

これを6つのアプローチの中で最も有望だと考えるかもしれませんが、それでも即時の爆発的な結果は得られないでしょう。私たちや他の人間の専門家が正確に推論を書き留めることに依存しているからです。

顔のない無慈悲なショゴが宇宙を解き明かすのではなく、教師を模倣する学生のようなものです。

もちろん、OpenAIのCTOであるMira Muratiが、彼らには舞台裏で巨大なブレイクスルーはないと言っているあいまいなクリップを見たことがあるでしょう。

「私たちは、これらの高性能なモデルを持っています。それらは、一般の人が無料でアクセスできるものからそれほど先を行っているわけではありません。そして、それは歴史的に見て、技術を世界にもたらすための完全に異なる軌道なのです」

しかし、今日お見せしたように、すべてか無かのどちらかである必要はありません。すぐにAGIが来るか、すべてがハイプかのどちらかではありません。

フランソワ・シャレが言うように、例えばARCを解決するのは、アプローチの組み合わせかもしれません。実際、それがAGIへの道かもしれません。

「人々は、ARコンペティションで勝利し、ニアターム型AIに向けて最も進歩するでしょう。彼らは、深い計画パラダイムと離散的探索パラダイムを1つのエレガントな方法にまとめることに成功するでしょう」

今日は触れられなかったことがたくさんありますが、このビデオが現在のAI の状況を理解するのに役立ったことを願っています。いつものように、世界は見たままよりも複雑なのです。

ご視聴ありがとうございました。素晴らしい一日をお過ごしください。

コメント